Reconhecimento Facial: um Pouco de História e Principais Abordagens

Os humanos baseiam-se frequentemente na face para o reconhecimento de indivíduos. Por sua vez, os avanços das últimas décadas na capacidade de computação permitem actualmente um reconhecimento similar, mas de forma automática. Os primeiros algoritmos de reconhecimento da face utilizavam modelos geométricos simples, mas o processo de reconhecimento já atingiu um nível de maturidade que lhe permite apresentar-se como uma ciência de representações matemáticas sofisticadas e processos de comparação.

Os grandes avanços e iniciativas registados nos últimos 10 a 15 anos trouxeram a tecnologia de reconhecimento da face para a ribalta. O reconhecimento de face pode ser utilizado actualmente tanto para fins de verificação, como de identificação.

Um pouco de história

O reconhecimento automatizado da face é um conceito relativamente novo. Desenvolvido na década de 1960, o primeiro sistema semi-automatizado para o reconhecimento da face exigia que o seu administrador localizasse características nas fotografias (por exemplo, olhos, orelhas, nariz e boca) antes do sistema calcular distâncias e rácios para um ponto de referência comum. Esse ponto de referência era depois comparado com os dados disponíveis.

Na década de 1970, Goldstein, Harmon, e Lesk utilizaram 21 marcadores subjectivos específicos - incluindo a cor do cabelo e a espessura dos lábios - para automatizarem o reconhecimento. O problema com estas duas soluções iniciais residia no facto das medições e localizações terem de ser calculadas manualmente.

Em 1988, Kirby e Sirovich aplicaram o princípio da análise de componentes, uma técnica de cálculo standard, ao problema do reconhecimento da face. Isto foi considerado como uma espécie de marco, na medida em que mostrou que eram necessários menos de uma centena de valores para codificar com exactidão uma imagem da face adequadamente normalizada e alinhada.

Em 1991, Turk e Pentland descobriram que, apesar da utilização de técnicas eigenfaces, o erro residual podia ser utilizado para detectar faces em imagens. Esta descoberta permitiu a criação de sistemas automatizados de reconhecimento da face em tempo real. Esta abordagem estava limitada de certa forma por factores ambientais, mas acabou por motivar um grande interesse para o desenvolvimento futuro de tecnologias de reconhecimento automatizado da face.

A tecnologia começou por chamar a atenção pública devido à reacção dos meios de comunicação a uma implementação experimental no January 2001 Super Bowl, que capturou imagens de vigilância e as comparou com uma base de dados de conteúdos digitais. Esta demonstração iniciou a necessária análise sobre a forma de utilizar a tecnologia para suportar determinadas necessidades nacionais, considerando ao mesmo tempo as preocupações sociais e de privacidade.

Actualmente, a tecnologia de reconhecimento da face está a ser utilizada para o combate à fraude com passaportes, para o reforço de legislação, para a identificação de crianças desaparecidas, e para minimizar as fraudes de benefícios/identidade.

Abordagens mais utilizadas

Existem duas abordagens predominantes relativamente ao problema do reconhecimento da face: a abordagem geométrica (baseada em características) e a abordagem fotométrica (baseada na visualização). Com a continuidade do interesse dos investigadores pelo reconhecimento da face, foram desenvolvidos vários algoritmos diferentes, com três deles a serem objecto de um grande estudo na literatura sobre o reconhecimento da face. São eles o Principal Components Analysis (PCA), Linear Discriminant Analysis (LDA), e Elastic Bunch Graph Matching (EBGM).

a) Principal Components Analysis (PCA)

A análise PCA - referida normalmente como baseando-se na utilização de eigenfaces, é uma técnica avançada por Kirby e Sirivich em 1988. Com a PCA, a imagem a pesquisar e as imagens da base de dados têm de ter as mesmas dimensões, e precisam de ser previamente normalizadas para alinhar os olhos e a boca nas imagens. A abordagem PCA é utilizada consequentemente para reduzir a dimensão dos dados, através da compressão dos mesmos, revelando a estrutura dimensional eficaz mais reduzida dos padrões faciais.

Esta redução das dimensões remove informação que não é útil e decompõe a estrutura da face em componentes ortogonais (não correlacionadas), conhecidas pela designação de eigenfaces. Cada imagem da face pode ser representada como a soma (vector de características) das eigenfaces que estão armazenadas num conjunto 1D. Uma dada imagem a pesquisar será então comparada com uma galeria de imagens, medindo a distância entre os seus respectivos vectores de características.

Figura 1. Eigenfaces standard. Os vectores de características

são derivados utilizando eigenfaces.

A abordagem PCA exige normalmente a apresentação de toda a imagem frontal da face. Caso contrário, a imagem apresentará baixos desempenhos. A principal vantagem desta técnica tem a ver com a possibilidade de redução dos dados necessários para identificar os indivíduos, com base num rácio de 1/1000 (uma para mil) dos dados apresentados.

b) Linear Discriminant Analysis (LDA)

A LDA é uma abordagem estatística para a classificação de amostras de classes desconhecidas com base em amostras preparadas com classes conhecidas. Esta técnica destina-se a maximizar a diferença entre classes (ou seja, entre utilizadores), e a minimizar a diferença dentro das classes (ou seja, nos utilizadores).

Figura 2. Exemplo de seis classes utilizando a LDA.

Na Figura 2, cada bloco representa uma classe e verifica-se uma grande diferença entre classes, mas pouca diferença dentro das classes. Quando se lida com dados de faces altamente dimensionais, esta técnica enfrenta o problema da pequena dimensão da amostra, que surge quando existe um pequeno número de amostras preparadas disponíveis, comparativamente à dimensão do espaço de amostra.

c) Elastic Bunch Graph Matching (EBGM)

A EBGM baseia-se na ideia de que as imagens de faces reais têm várias características não lineares que não são consideradas pelos métodos de análise linear - por exemplo, variações na iluminação (luz exterior versus iluminação interior), na postura (postura mais rígida versus postura mais descontraída), ou na expressão (sorriso versus cara mais séria).

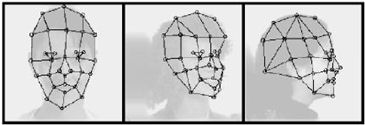

Uma conversão wavelet Gabor cria uma arquitectura dinâmica de ligações que projecta a face numa grelha elástica. O jet Gabor é um nó na grelha elástica, assinalados por círculos na imagem em baixo, que descreve o comportamento da imagem em torno de um dado pixel. É o resultado de uma confluência da imagem com o filtro Gabor, que é utilizado para detectar formas e para extrair características utilizando o processamento de imagem. Uma confluência expressa a quantidade de sobreposição de funções, misturando-as. O reconhecimento baseia-se na similaridade da resposta do filtro Gabor em cada nó Gabor.

Figura 3. Elastic Bunch Map Graphing.

Este método baseado em características biológicas, utilizando filtros Gabor, é um processo executado no cortex visual dos mamíferos superiores. As dificuldades deste método têm a ver com a necessidade de uma localização exacta, algo que pode ser conseguido por vezes através da combinação dos métodos PCA e LDA.

Baseado num documento com o título "Face Recognition", publicado pelo NSTC (National Science and Technology Council) Subcommittee on Biometrics.

Produzido em 2008